Dữ Liệu Trí Tuệ Nhân Tạo: Vì Sao Dữ Liệu Là Linh Hồn Của AI, Chứ Không Phải Thuật Toán?

Trí tuệ Nhân tạo (AI) đã trở thành động lực thúc đẩy sự đổi mới trong mọi ngành công nghiệp. Tuy nhiên, đằng sau mỗi mô hình AI đột phá, từ ChatGPT, Google Gemini đến các hệ thống nhận diện hình ảnh phức tạp, không phải là một thuật toán ma thuật, mà là một kho báu ít được nhắc đến: Dữ liệu. Dữ liệu không chỉ là nguyên liệu, mà chính là linh hồn của trí tuệ nhân tạo. Bài viết này sẽ phân tích chi tiết vì sao dữ liệu trí tuệ nhân tạo lại có vai trò sống còn và cách thức nó định hình tương lai AI.

I. Giải phẫu mối quan hệ giữa dữ liệu và mô hình AI

Machine Learning (Học máy) là quá trình tự động hóa việc xây dựng mô hình phân tích. Quá trình này hoàn toàn phụ thuộc vào việc “tiêu thụ” và học hỏi từ các tập dữ liệu AI được cung cấp.

1. Dữ liệu: thức ăn nuôi dưỡng trí thông minh

Mô hình AI học hỏi bằng cách tìm kiếm các mẫu (patterns), mối quan hệ, và sự tương quan ẩn giấu bên trong tập dữ liệu. Nếu dữ liệu không đủ phong phú, mô hình sẽ bị “suy dinh dưỡng,” dẫn đến:

- Overfitting (Học vẹt): Mô hình hoạt động rất tốt trên dữ liệu huấn luyện nhưng thất bại hoàn toàn khi đối mặt với dữ liệu thực tế mới.

- Underfitting (Học kém): Mô hình quá đơn giản, không thể nắm bắt được các mối quan hệ phức tạp trong dữ liệu, dẫn đến hiệu suất thấp.

Để tránh những rủi ro này, các kỹ sư cần một lượng dữ liệu lớn (Big Data) và phải đảm bảo dữ liệu đó đại diện cho toàn bộ miền vấn đề mà AI cần giải quyết.

2. Sự khác biệt giữa dữ liệu có gán nhãn và không gán nhãn

- Học có Giám sát (Supervised Learning): Yêu cầu dữ liệu có gán nhãn (Labeled Data). Ví dụ: Phải gán nhãn cho hàng triệu bức ảnh (Đây là Mèo, Đây là Chó) để mô hình có thể học cách phân biệt. Đây là công đoạn tốn kém và mất thời gian nhất, nhưng là cốt lõi của các ứng dụng AI thương mại phổ biến.

- Học Không Giám sát (Unsupervised Learning): Sử dụng dữ liệu không gán nhãn để tìm kiếm cấu trúc hoặc phân cụm (clustering) dữ liệu.

- Học Tăng cường (Reinforcement Learning): Dữ liệu được tạo ra thông qua sự tương tác của tác nhân (Agent) với môi trường, nhấn mạnh vai trò của dữ liệu động.

II. Tiêu chuẩn vàng: Vai trò sống còn của chất lượng dữ liệu AI

Không phải cứ nhiều dữ liệu là tốt. Trong bối cảnh AI, chất lượng dữ liệu AI luôn được ưu tiên hơn số lượng. Dữ liệu chất lượng cao phải đáp ứng các tiêu chí sau:

1. Tính chính xác và hoàn chỉnh (Accuracy and Completeness)

Dữ liệu phải đúng sự thật và không bị thiếu sót. Một điểm dữ liệu bị lỗi hoặc thiếu có thể kéo theo sự suy giảm hiệu suất của toàn bộ mô hình.

- Minh họa: Trong chẩn đoán y tế bằng AI, một tập dữ liệu X-quang thiếu thông tin về tuổi hoặc tiền sử bệnh nhân (dữ liệu không hoàn chỉnh) có thể khiến mô hình đưa ra dự đoán sai lệch, gây hậu quả nghiêm trọng.

2. Tính nhất quán và tính kịp thời (Consistency and Timeliness)

- Nhất quán: Dữ liệu từ các nguồn khác nhau phải sử dụng cùng một định dạng, đơn vị đo lường. Nếu không nhất quán, mô hình sẽ học được các mẫu mâu thuẫn.

- Kịp thời: Với các lĩnh vực như tài chính hoặc dự báo thời tiết, dữ liệu trí tuệ nhân tạo cần phải được cập nhật gần với thời gian thực (real-time) để mô hình đưa ra quyết định kịp thời và phù hợp.

3. Đối phó với thiên vị dữ liệu (Data Bias Mitigation)

Thiên vị dữ liệu (Data Bias) là một thách thức đạo đức và kỹ thuật lớn nhất. Khi dữ liệu AI phản ánh định kiến xã hội hiện có (ví dụ: thiên vị giới tính, chủng tộc, hoặc vị trí địa lý), mô hình học từ đó sẽ nhân rộng và củng cố những định kiến đó.

- Giải pháp: Áp dụng các kỹ thuật như phân tích độ chênh lệch (disparity analysis), lấy mẫu lại (resampling) và sử dụng các công cụ giám sát Bias trong quá trình huấn luyện mô hình (Bias monitoring tools) để xây dựng một dữ liệu trí tuệ nhân tạo công bằng và vô tư hơn.

III. Quản lý dữ liệu hiện đại: DataOps và kỷ nguyên LLMs

Trong các hệ thống AI cấp doanh nghiệp, việc quản lý dữ liệu AI đã phát triển thành các quy trình phức tạp, cần sự tự động hóa và tích hợp.

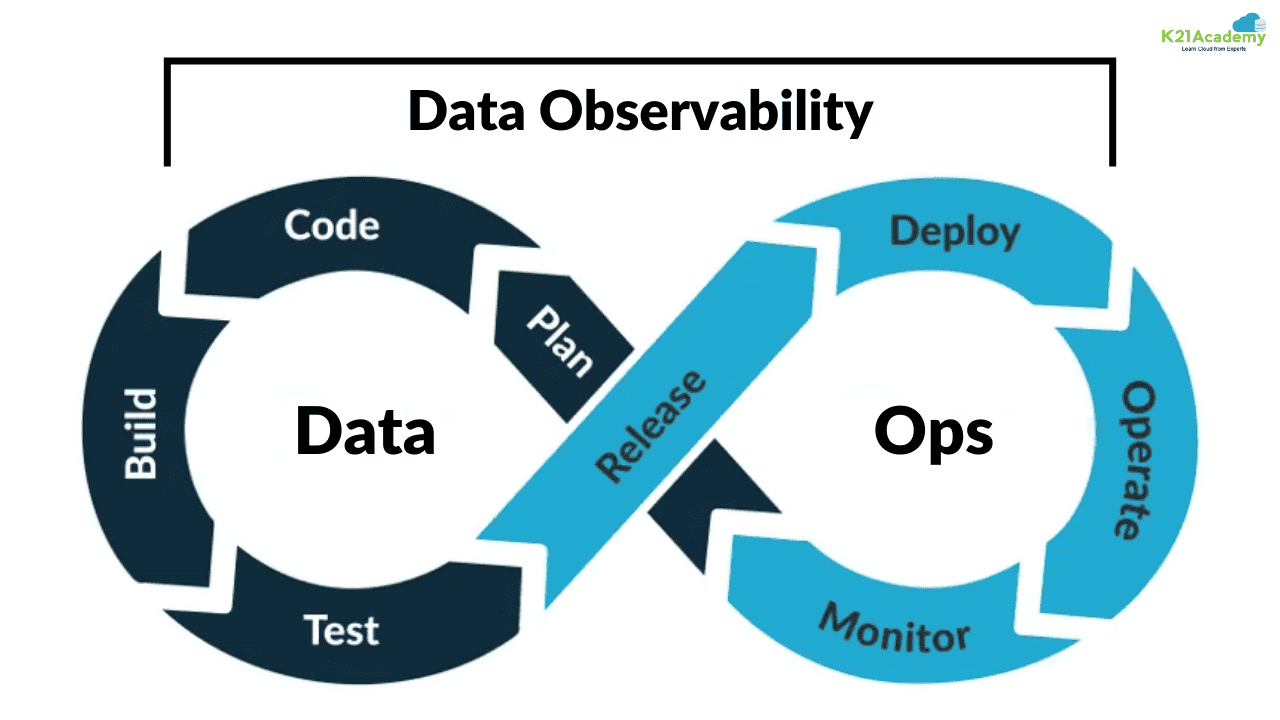

1. DataOps: Vận Hành Dữ Liệu cho AI

DataOps là sự kết hợp giữa “Data” (Dữ liệu) và “Operations” (Vận hành), nhằm mục đích cải thiện chất lượng, tốc độ và khả năng cộng tác trong quản lý dữ liệu. Đối với AI, DataOps đảm bảo:

- Pipeline Tự động: Tự động hóa quá trình di chuyển, làm sạch và gán nhãn dữ liệu trí tuệ nhân tạo.

- Kiểm soát Phiên bản Dữ liệu (Data Versioning): Giúp các kỹ sư biết chính xác mô hình nào được huấn luyện bằng tập dữ liệu nào, đảm bảo khả năng tái tạo kết quả.

2. Dữ liệu cho mô hình ngôn ngữ lớn (LLMs)

Sự bùng nổ của các LLMs như GPT-4 hay Gemini đã tạo ra nhu cầu mới về dữ liệu:

- Dữ liệu huấn luyện thô (Pre-training Data): Một lượng khổng lồ dữ liệu văn bản không gán nhãn từ Internet để mô hình học cấu trúc ngôn ngữ.

- Dữ liệu tinh chỉnh (Fine-tuning Data): Tập dữ liệu nhỏ hơn, chất lượng cực cao và được gán nhãn rất cẩn thận để dạy mô hình thực hiện các tác vụ cụ thể (ví dụ: trả lời theo phong cách công ty). Đây là nơi chất lượng dữ liệu AI quyết định hiệu suất của ứng dụng AI cuối cùng.

IV. Kết luận: Tương lai của trí tuệ nhân tạo chính là cuộc chiến dữ liệu

Dữ liệu – linh hồn của trí tuệ nhân tạo – là tài sản chiến lược quan trọng nhất của mọi công ty trong kỷ nguyên AI. Sự thành công của một dự án AI phụ thuộc 80% vào chất lượng của dữ liệu đầu vào.

Việc đầu tư vào chiến lược DataOps mạnh mẽ, tập trung vào tính toàn vẹn, đa dạng và đạo đức của dữ liệu trí tuệ nhân tạo không chỉ là một yêu cầu kỹ thuật, mà còn là một trách nhiệm xã hội. Các công ty làm chủ được dữ liệu của mình sẽ là những người dẫn dắt tương lai của AI.